Esta es una aplicación de los sistemas basados en HRTF alejada de los tradicionales usos en servicios multimedia que se suelen exponer al hablar de estas técnicas. En este caso, el Instituto de Astrofísica de Canarias, junto a la Universidad de La Laguna, entre otras instituciones, han desarrollado un dispositivo electrónico capaz de recrear el entorno inmediato de una persona utilizando únicamente sonido, con especial aplicación en personas ciegas.

En el usuario, se crea la ilusión de que los objetos que lo rodean están cubiertos de pequeñas fuentes sonoras, emitiendo de una forma característica y mantenida en el tiempo. Así, se recrea un mundo virtual sonoro, en que los cuerpos físicos producen sonidos desde sus superficies.

El desarrollo de la técnica se fundamenta en:

En el sistema nervioso central se han identificado áreas donde confluye información procedente de diferentes modalidades sensoriales. Una de ellas es la corteza parietal posterior. Esta región está implicada en la consecución de una correcta percepción espacial y de las relaciones espaciales de los objetos entre sí y con respecto al observador.

Estudios neurofisiológicos recientes revelan su posible papel en la generación de la representación espacial del entorno. El hecho de que parezca existir un mismo sustrato multimodal para la generación de una representación cerebral del espacio físico que nos rodea, inspira la idea de que esa representación, que mayoritariamente es conformada a partir de información visual, puede lograrse a partir de información procedente de los otros sentidos. En esta dirección, se han abordado desde hace décadas estudios tendentes a percibir imágenes a partir de estimulación tactil.

|

Representación gráfica

del entorno percibido. |

Desde el campo de los estudios psicológicos y psicofísicos, existen referencias a la capacidad de las tanto de la persona ciega como con visión normal, de percibir formas y tamaños de objetos a partir de los sonidos emitidos por éstos. La utilización de sonidos para percibir el entorno es aprovechada espontáneamente por muchas personas deficiente visuales a partir del sonido, ecos y reverberación de sus propios pasos o de sonidos generados ex profeso como chasquidos de dedos, susurros, silbidos, etc. y se conocen técnicamente como ecolocación.

Ejemplo en que se representa la

formación de la imagen sonora en una persona vidente y en una

ciega. |

En algunas ayudas técnicas se ha utilizado el sonido únicamente como indicador de presencia o no de un objeto y su posible distancia, en el caso de los denominados detectores de obstáculos. La línea de investigación más cercana a nuestro planteamiento, viene de la mano del Dr. Kay en Nueva Zelanda, un dispositivo basado en ultrasonidos pretende generar un conocimiento del entorno de una manera cuasi global, pero tras aprender un código y basando el reconocimiento de objetos en el aprendizaje de un patrón sonoro concreto o específico, difícil de interpretar por nuestro sistema nervioso central y por lo tanto mal tolerado por el grupo de usuarios.

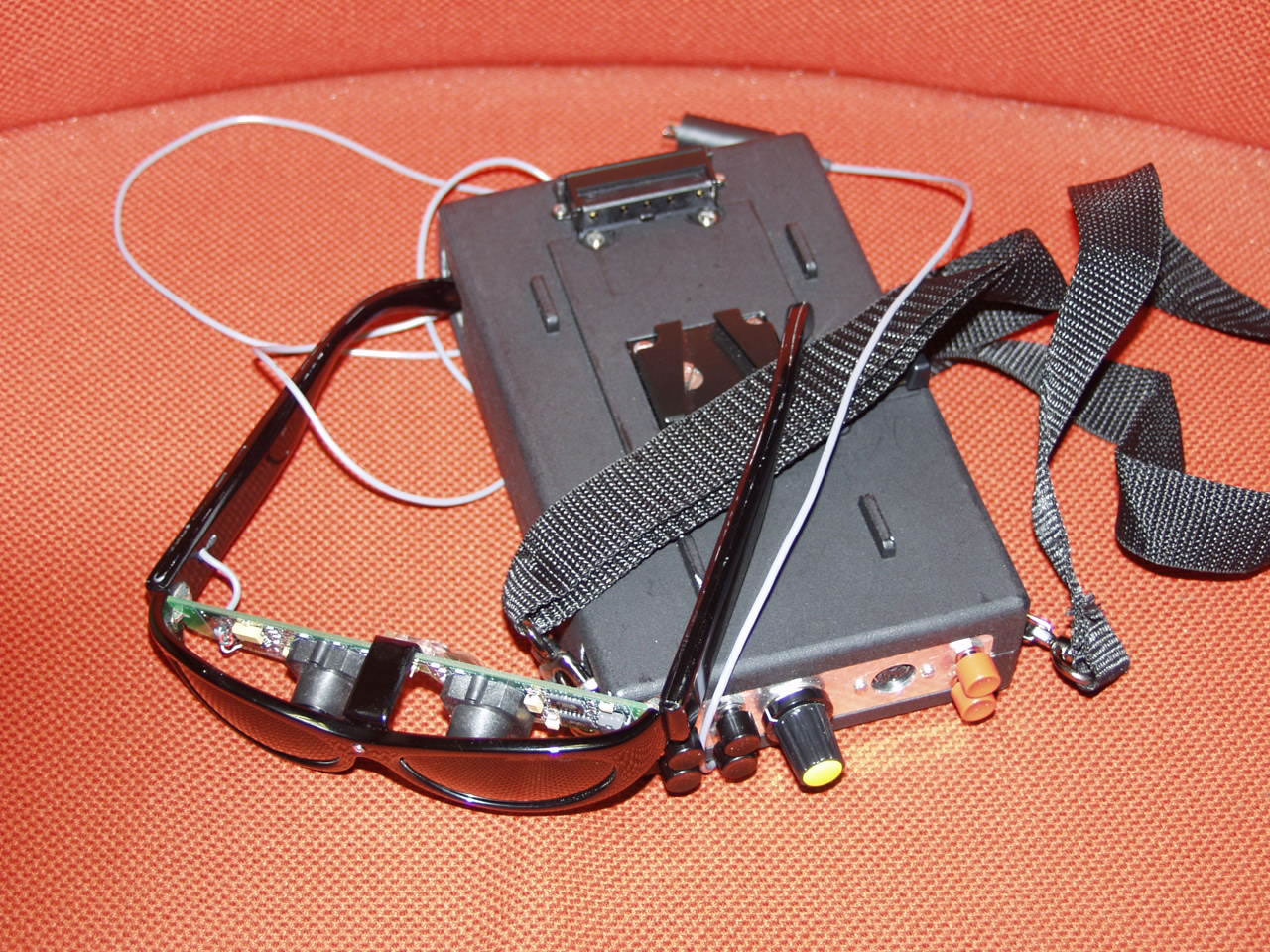

Al objeto de obtener una verificación experimental de las ideas descritas anteriormente, ha sido desarrollado un prototipo experimental capaz de capturar las características tridimensionales del espacio que rodea al deficiente visual, transformarlas en parámetros sonoros y reproducir el conjunto mediante auriculares. Este sistema permite localizar virtualmente una fuente sonora en el espcio por cada grupo de pixeles de la imagen (dependiendo de la resolución del sistema), todo lo cual se realiza a tiempo cuasi real (10 a 12 imágenes por segundo) de forma que la persona ciega pueda interaccionar con el entorno. Para auralizar las fuentes sonoras es necesario calcular las funciones de transferencia relativas a la forma de la cabeza (HRTFs) de cada voluntario ciego y sus correspondientes controles sin problemas visuales, para lo que se ha desarrollado también un sistema que permite cuantificarlas para las posiciones del espacio necesarias dada la resolución requerida.

El sistema construido consta de tres partes básicas. Un sistema de visión artificial, un sistema de generación de sonidos tridimensional y una interfase de control, teniendo el primero la misión de obtener una evaluación cuantitativa del entorno físico del usuario, el segundo la de producir, combinar y llevar hasta éste los sonidos que correspondan, y el tercero la organización de los dos primeros.

El sistema de visión artificial registra las formas del entorno del sujeto mediante dos microcámaras de vídeo situadas en la cabeza a la altura de los ojos, colocadas sobre un soporte diseñado al efecto. La señal de estas cámaras se conduce mediante un enlace radio hasta el ordenador que procesa la información y obtiene una descripción informática de dicho entorno, utilizando para ello los algoritmos de visión artificial (esterovisión, tamaños aparentes de motivos conocidos, etc.) en un laboratorio de ensayos acondicionado para este proyecto, y que permite simular diversos entornos cotidianos.

El sistema de generación de sonidos recoge la información de

la estructura del entorno, para crear la percepción de que cada uno de

esos sonidos proviene (está localizado) del lugar que ha indicado la

captación del entorno, a través de unos auriculares inalámbricos

que también forman parte del soporte que la persona ciega porta, y utilizando

para ello las funciones de transferencia descriptivas de la cabeza (HRTF) que

se han medido previamente para cada sujeto en particular.